鑫捷科技(Webplus)專精於AI整合、資訊安全、系統與網路建置、虛擬化、大數據分析及軟體開發,提供一站式企業IT解決方案,服務涵蓋從網路連線到端點安全,涵括雲端資訊整合、資料備份、系統備援規劃等,協助臺灣及海外政府機關與中大型企業客戶規劃與整合資訊系統,共創資訊科技新未來。

隨著人工智慧(AI)技術的迅速發展,高效能計算需求與日俱增。NVIDIA 將於2024年底推出全新一代平台 Blackwell,這一舉措預計將推動大型雲端服務提供商(CSP)建設新的 AI 伺服器資料中心。TrendForce 的最新報告指出,這將有望使液冷散熱方案的滲透率在年底前達到10%。Blackwell 平台預計於2025年正式放量,取代現有的 Hopper 平台,成為 NVIDIA 高階 GPU 的主力方案,預計占整體高階產品的83%。

液冷技術:應對AI高耗能需求的最佳選擇

Blackwell 平台的高效能 AI 伺服器,如 B200 和 GB200,單顆 GPU 功耗可達1,000W,HGX 機種每台裝載8顆 GPU,NVL 機種每櫃最多可達72顆 GPU。如此巨大的能耗推動了液冷散熱供應鏈的成長。傳統氣冷散熱方案已經無法應對這些需求,尤其是 GB200 NVL36 和 NVL72 整機櫃的熱設計功耗(TDP)分別高達70kW和140kW,需要更高效的液冷方案來有效解決散熱問題。

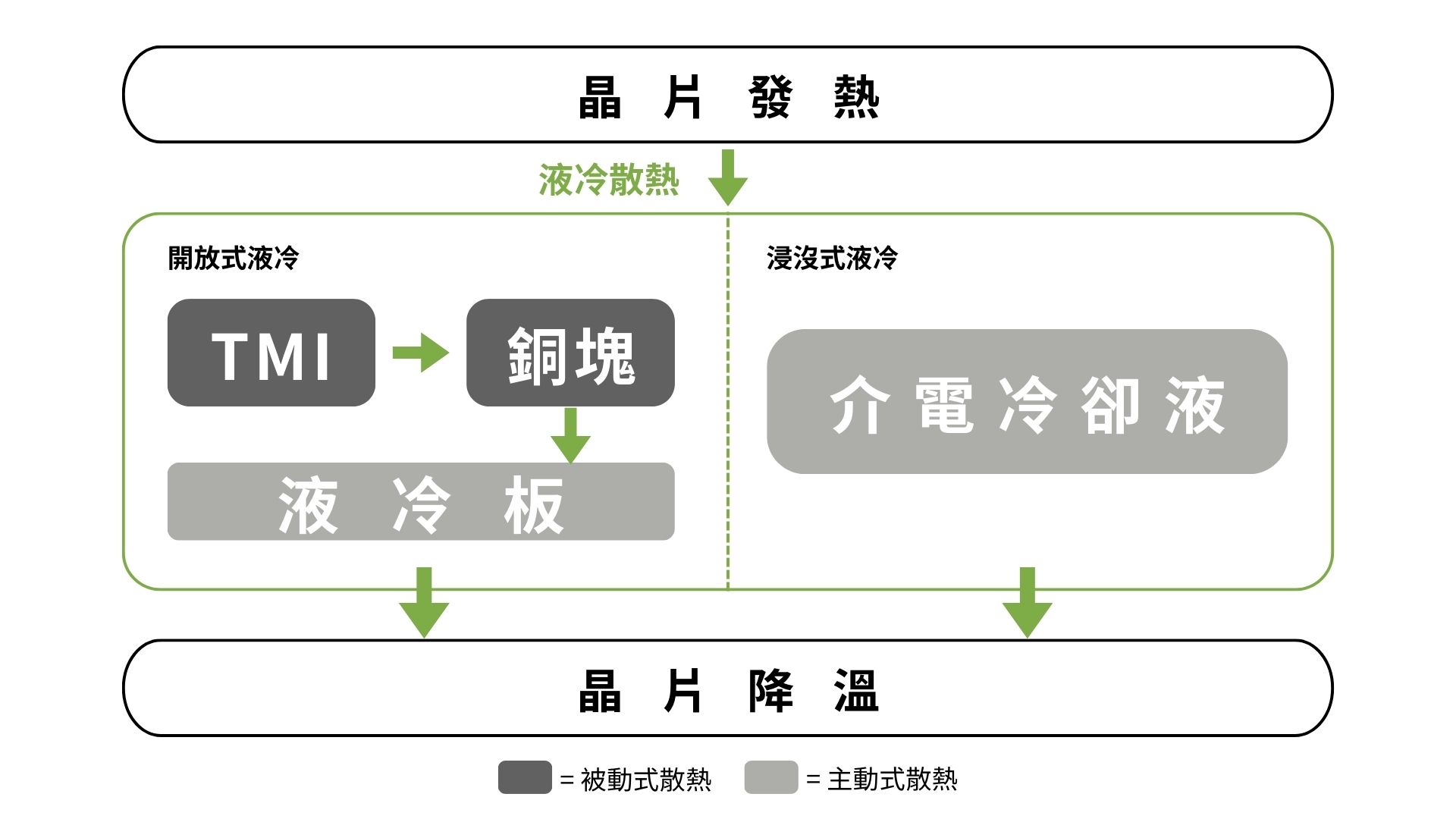

液冷技術,尤其是直接液體冷卻(DLC),提供了比傳統氣冷方案更高的散熱效率。液冷方案包括水冷板(Cold Plate)、冷卻分配系統(Coolant Distribution Unit, CDU)、分歧管(Manifold)、快接頭(Quick Disconnect, QD)和風扇背門(Rear Door Heat Exchanger, RDHx)。其中,CDU 是液冷系統的關鍵組件,負責調節冷卻劑流量,確保機櫃溫度控制在預設的 TDP 範圍內。

市場趨勢與供應鏈發展

TrendForce 報告顯示,NVIDIA AI 方案目前主要依賴 Vertiv 作為 CDU 供應商,而奇鋐、雙鴻、台達電和 CoolIT 等公司則正在測試並驗證液冷系統的其他關鍵零組件。隨著 NVIDIA 積極擴展 CSP 客群,預計2025年 GB200 折算 NVL36 的出貨量將達6萬櫃,而 GB200 的 Blackwell GPU 用量則可達210萬至220萬顆。

未來,NVIDIA 計劃推出多種 AI 伺服器組態,包括 HGX、GB200 Rack 和 MGX,分別針對 CSP 和企業型客戶。預計這三個機種的出貨比例將約為5:4:1。HGX 平台能夠無縫接軌既有的 Hopper 平台設計,使 CSP 或大型企業客戶能夠迅速採用。GB200 整櫃 AI 伺服器方案則主要針對超大型 CSP 市場。TrendForce 預計 NVIDIA 將於2024年底率先導入 NVL36 組態,以求快速進入市場。NVL72 由於其更複雜的設計和散熱系統,預計將於2025年推出。

液冷方案的挑戰與前景

儘管液冷方案能夠有效應對高效能 AI 伺服器的散熱需求,但其設計和實施仍面臨諸多挑戰。液冷機櫃設計更適合新建資料中心,但涉及土地和建築規劃等複雜程序。此外,CSP 可能不希望受制於單一供應商的規格,可能選擇其他搭載 x86 CPU 架構的機種,或擴大自研 ASIC AI 伺服器基礎設施,以降低成本或針對特定 AI 應用情境。

在此背景下,從直接液體冷卻(DLC)到浸沒式冷卻,乃至經過改良的氣冷配置,滿足不同客戶的需求。這些先進的冷卻技術不僅能夠提升 AI 伺服器的算力,還能降低使用者的碳足跡和營運成本(OpEx),實現更強大且可持續的 AI 運算。

資料來自:TechNews